CVPR論文のトピックモデルによる分類と傾向

コンピュータビジョンの国際学会CVPRの最近の論文全文をトピックモデルに基づいて分類、単語分布を可視化できたのでその結果を手短にまとめます。図を見てもらったほうが早いかもしれません。

手法

https://github.com/colincsl/cvpr2013papers

からforkした

https://github.com/xiangze/cvpr2013papers

を使って論文のダウンロード、全文text化を行いました。さらにgensimを用いてcorpus、辞書の作成、LDAによるトピックの分類を行い(genLDA.py)、pyLDAvisで可視化(genpages.py)しました。

LDAvisはもともとRのパッケージでshinyでクラスタリングの結果を可視化、共有する出来ます。pyLDAvisは見た目は同じでwebページのほかにipython notebook(Jupyter)として表示が出来ます。

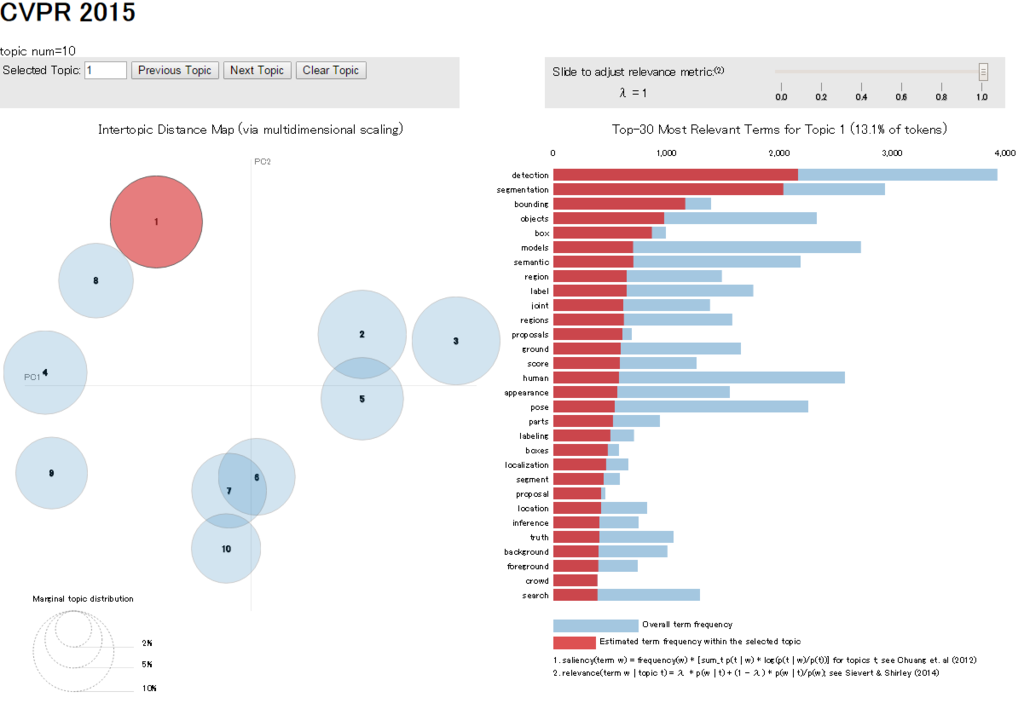

図の見方ですが、左側には各トピックを多次元尺度法(MDS)で2次元に落として配置したものが表示され、円の大きさは各トピックに所属するdocument(論文)の合計をあらわしています。

右側には選択したトピックの頻出単語、同トピック内での出現頻度が大きい単語とその頻度が表示されます。右下に説明がありますが、パラメータλを変えると出現頻度、同トピック内での出現頻度の割合の比率を変えて順位を変えられます。

右側の単語にマウスを重ねると各トピック内における出現頻度が左側の円の大きさとして表示されます。

結果の説明

まずcv-foundation.orgからリストが取得できる2013年以降の結果についてその変遷を見ていきます。

論文総数は

2013 471

2014 540

2015 602

となり増加傾向にあります。

各トピックで多く出現する単語、割合の多い単語をλを変えながら見てピックアップしたものが以下になります。

2015年トピック数=10と固定した場合の各トピックの傾向

https://dl.dropboxusercontent.com/u/27452774/CVPRpapers2015_10.html

- 1: object detection & segmentation

bounding box,crowd なぜかproposalが多いらしいです。

- 8: contour

material,scene,cnnが多く、humanが少し多いです。

対象は1に近いですが、輪郭、ニューラルネットに近いことなど手法に違いがあるようです。

semantic text wordなど文章、自然言語処理との対応が見られます。hash,LSHなどといった単語の割合も多く、neural deepといった語も含まれています。

- 9: deep learning(face)

もっともdeep learningらしいトピックです。cnn,layer,convolutionalなど専門的な単語が並んでいます。適用例としてはfaceが多いようです。

- 10: face(sparse,辞書学習)

適用対象はfaceで9番と同じようですが、手法が異なるようです。sparse,dictionaryなどが特徴的です。

- 7:動画からの動作推定

video motion action,trajectoryなどが頻度が多いです。Riemannian,manifold,grassmanなど難しそうな数学的手法の出現頻度が多いです。

- 6: saliency

saliency(顕著性)はほぼこのトピックにのみ限定されます。binary,quantizationなど4番の手法と共通するものがありますが、位置的には離れています。

- 5:行列分解?

convex,matrix,solving,submodularなど数学的な研究で個人的には最も特徴が掴みにくかったです。ビジョン特有の単語はあまり見られませんでした。

- 2: 3次元復元?

matching,gaze,eye,disparity,registration,correspondenceなど視差画像のマッチングに関するものでしょうか。

- 3: depthと光線

camera,light,blur,sensor,illuminaitonなどが多いです。物体の形状、種類ではなく光に着目した研究のようです。

大まかには1,8,4,9(物体検出、deeplearning), 10,7,6(動画、動作、顕著性) ,5(数学より),2,3(3次元、実世界より)のようなまとまりに見えました。

2014年のtopic(topic number=10)

https://dl.dropboxusercontent.com/u/27452774/papers2014.html

- 5: saliency

fisher kernel?, neural,deepなども混ざっています。

- 1: segmentation

attribute,labeling,superpixelなど2015年の8に近いです。

- 4: face blur

video actionなど動画に関するものですがfaceも多いです。

- 8:pose, body

人体のポーズや部分(head,eye,limb)の推定に関する研究のようです。

- 2:detection tracking bounding box

2015年の1に近いです。

- 7: shape disparity

2015年の2に近いです。

- 10: motion surface occlution

SfMがあるなど再構成のようですが動き(motion,trajectory)の要素もあります。

- 3: camera,depth,point light

2015年の3に近いです。

- 6 matrix subspace,euclidian,

2015年の5に近いです。Riemanian,manifold,Hilbertなども多い。

- 9:binary hash tensor denoising

hashing,圧縮などの研究です。適用対象は動画、動きなどのようです。

2013年のtopic(topic number=10)

https://dl.dropboxusercontent.com/u/27452774/papers2013.html

- 2: detection bounding box

svm hogなどが主要として頻度が高い。

- 7: pose,body attribute, active

- 6: tracking word crowd trajectory

topic

- 5:video action,spatio-temporal

hash,quantizationなど2014年の9に似ている。

- 10: saliency

- 1:face,matrix,clustering

spectral

- 8:segmentation,superpixel

kernel,manifoldがやや多い

- 9:blur,denoize

- 3:camera,point ,shape

light,distortion,calibration

- 4:depth

傾向

安定した傾向として

- bounding boxを使った群集検出の研究

- 光学系の研究

- depth(深さ)情報を用いるような研究

- saliencyの研究

- 行列分解などの数学的手法

などの流れがあります。

一方2013年にはほとんど目立たなかったニューラルネット系の研究が2014年には多くなり始め、2015年には複数のトピックを形成するにいたっています。ニューラルネットの流行と同時に自然言語処理との結びつきも強くなり、hashを用いた研究はニューラルネット、自然言語処理のクラスタに飲み込まれてしまったようにも見えます。

顔検出、顔識別は大きな分野らしく、複数のトピックに分かれています。その他の人体の各部位や人間の動作の推定の研究も多いですが、手法には変遷があるようです。

多様体、リーマン幾何などの数学的概念は行列分解のところのほかに動作、動画に関する研究で出現頻度が高いです。

2015年topic数15のときの結果

より細かい傾向が見れます。

https://dl.dropboxusercontent.com/u/27452774/CVPRpapers2015_15.html

- 11: action, human, attribute

- 1: pascal VOC,bounding box,cnn, semantic,

- 15: saliency, attention

- 12: text,word, language,

- 7: layer, cnn,nn,pooling, architecture

- 14: tracking crowd, gaze

- 3: domain,label, class, active, ?

- 8: face ,landmark, riemannian

ほとんどface

- 5: binary hashing,code,

- 9: shape,matching correspondence,

- 6:matrix,norm,low-rank

- 13: segmentation, boundary,pixel,

super pixel,foreground,background

- 4:video,motion, blur, frame, event

trajectory,egocentric

- 10: pose, depth, body

- 2: light, depth, surface, stereo

課題

- 複合語の扱いnltk.WordNetLemmatizerとかを使う。

- topic数が異なる場合の位置あわせ

あまり関係なさそうなトピックが重なって見えてしまう場合があり、トピック数を変えた場合と比較するしか方法がなさそう。

LDAと実装上の特性によるものかもしれません。MDSでは完全な分離は難しいかもしれない。

- トピック数を変えた場合の安定性(persistence?)

- ドメイン特化したモデル

研究対象と手法が分離できるようなトピックモデルはあるのかもしれません。

- 各トピックの時間的な変化をみるにはDTMを使った方がよさそうです。

DTMのプログラムとgensimからの使い方 https://github.com/mihurtado/dtm_gensim http://socialcomputing.ing.puc.cl/uploads/DynamicTopicModellingTutorial.pdf

Reference

- CVPR2015論文のキーワード、topicごとの表示、類似性の高い論文表示 @karpathyさん作成

http://cs.stanford.edu/people/karpathy/cvpr2015papers/

- [ScholarOctopus:title=http://cs.stanford.edu/people/karpathy/cvpr2015papers/render/index.html]

t-SNEによる論文BoWの次元削減らしいです。

関連書籍

LDAの変分ベイズによるパラメータの更新式の導出と回帰モデルへの適用、逐次推定、DTMなど発展的な内容が書かれています。むずいです。

トピックモデルによる統計的潜在意味解析 (自然言語処理シリーズ)

- 作者: 佐藤一誠,奥村学

- 出版社/メーカー: コロナ社

- 発売日: 2015/03/13

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (4件) を見る